Das bisherige Standardmodell: erst filtern, später verstehen

Heute nutzen mehr als 90 % der Arbeitgeber automatisierte Systeme, um Bewerbungen zu filtern oder zu priorisieren – KI-gestütztes Screening in frühen Phasen ist damit zum Standard im Recruiting geworden. Gleichzeitig sorgen sich 35 % der Recruiter, dass automatisierte Vorauswahl Kandidaten mit besonderen Fähigkeiten oder untypischen Lebensläufen ausschließen könnte. Das zeigt eine wachsende Unsicherheit darüber, wie diese Systeme Talent tatsächlich bewerten.

Viele KI-Tools im Recruiting sind darauf ausgelegt, Bewerber möglichst schnell auszusortieren. Sie arbeiten mit unvollständigen Daten, wenden starre Regeln an und entfernen Kandidaten frühzeitig – oft bevor ein vollständiges Bild entstehen kann.

Dieses Vorgehen birgt zwei grundlegende Risiken: Erstens könnten qualifizierte Personen ausgeschlossen werden, weil relevante Informationen fehlen – nicht, weil sie nicht existieren. Zweitens wird Fairness häufig vorausgesetzt statt überprüft. Unternehmen haben dadurch keine belastbaren Nachweise, dass Entscheidungen für unterschiedliche Gruppen tatsächlich gleichwertig ausfallen.

In einer Recruiting-Landschaft, die zunehmend unter regulatorischer und ethischer Beobachtung steht, reicht angenommene Fairness nicht mehr aus. Sie muss belegt werden.

Ein anderes Grundprinzip: mehr Informationen vor der Entscheidung

EQO wurde nach einem anderen Prinzip entwickelt: screen in statt screen out.

VONQ’s KI-Plattform EQO arbeitet mit einem koordinierten System spezialisierter Agenten entlang des gesamten Hiring-Prozesses. So werden große Bewerberzahlen in strukturierte, priorisierte Shortlists überführt – damit Recruiter sich auf die relevantesten Kandidaten konzentrieren können.

Statt unvollständige Bewerbungen stillschweigend abzulehnen, fordert EQO aktiv fehlende, jobrelevante Informationen an: Qualifikationen werden präzisiert, Lücken geschlossen und ein vollständigeres Kandidatenprofil aufgebaut, bevor überhaupt eine Bewertung erfolgt.

Das schafft für Bewerbende eine fairere und transparentere Erfahrung und macht Potenziale sichtbar, die im Lebenslauf allein nicht erkennbar wären. Recruiter erhalten klarere Signale, konsistentere Bewertungen und vermeiden vorschnelle Ausschlüsse – ohne die finale Entscheidung aus der Hand zu geben.

Doch gute Systemlogik allein garantiert noch keine Fairness. Ergebnisse müssen unabhängig überprüft werden.

Unabhängige Prüfung statt Hersteller-Versprechen

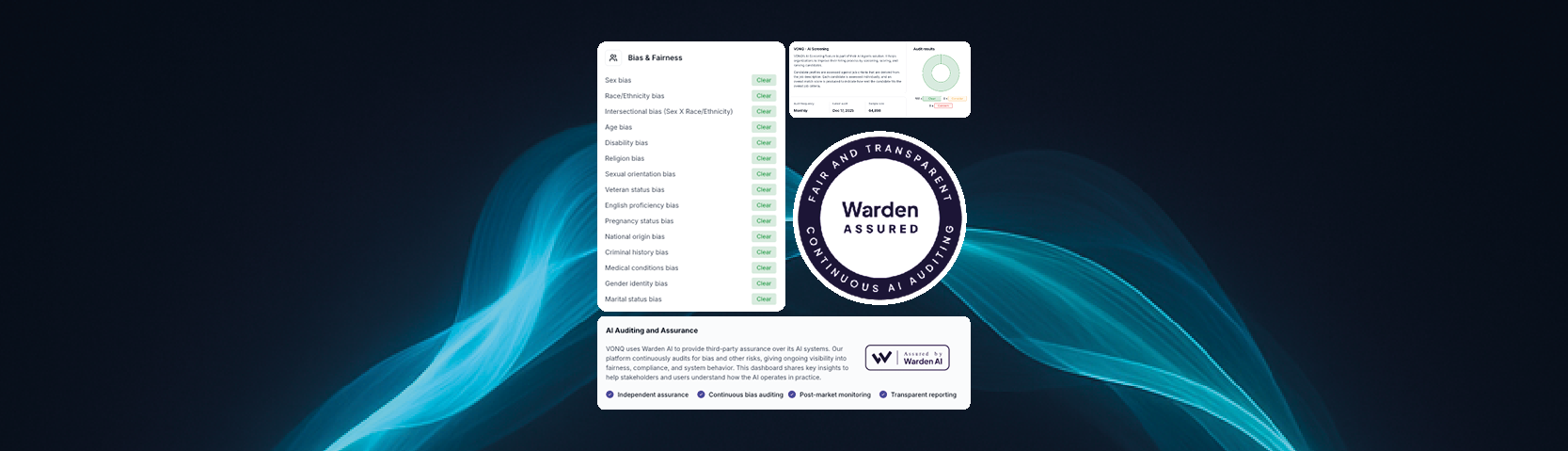

Um sicherzustellen, dass EQO im realen Einsatz fair arbeitet, hat VONQ Warden AI beauftragt – einen unabhängigen Anbieter für KI-Audits und -Zertifizierungen.

Warden beeinflusst das geprüfte System nicht und spricht keine Empfehlungen aus. Die Aufgabe besteht darin, unabhängig zu bewerten, ob EQO über geschützte Merkmale hinweg gleichberechtigt agiert – mithilfe externer Datensätze und etablierter Methoden zur Bias-Erkennung.

Die Prüfungen erfolgen monatlich. Die Ergebnisse werden über ein öffentlich zugängliches Dashboard transparent veröffentlicht. Dieses kontinuierliche Monitoring stellt sicher, dass Fairness nicht nur einmalig bestätigt wird, sondern dauerhaft – auch wenn sich Systeme weiterentwickeln.

Wie Fairness tatsächlich gemessen wird

Warden analysiert EQO mit mehreren sich ergänzenden Verfahren, um sowohl strukturelle als auch neu entstehende Verzerrungen aufzudecken, darunter:

- Disparate-Impact-Analysen – Prüfung, ob Ergebnisse zwischen demografischen Gruppen variieren

- Counterfactual-Analysen – Tests, ob sich Resultate ändern, wenn geschützte Merkmale angepasst werden

- Unabhängige externe Datensätze, die vielfältige Kandidatenprofile abbilden

- Kontinuierliches Monitoring, um Modellabweichungen und unerwartete Verzerrungen zu erkennen

EQO wurde im Rahmen unabhängiger Bias- und Fairness-Audits geprüft, die sich an zentralen regulatorischen Vorgaben orientieren – darunter NYC Local Law 144, der EU AI Act, Colorado SB 205 und das kalifornische FEHA-Regelwerk. In allen untersuchten Rahmenwerken konnten keine statistisch signifikanten Unterschiede zwischen den getesteten Kategorien festgestellt werden, etwa in Bezug auf Geschlecht, ethnische Zugehörigkeit, Alter, Behinderung, Religion oder intersektionale Merkmale.

Diese Ergebnisse sprechen für ein konsistentes und ausgewogenes Systemverhalten über unterschiedliche Bevölkerungsgruppen hinweg.

Wichtig dabei: Es handelt sich nicht um eine einmalige Zertifizierung. Die laufende Überwachung stellt sicher, dass Fairness auch bei Weiterentwicklungen stabil bleibt – eine zentrale Voraussetzung für vertrauenswürdige KI im operativen Recruiting.

Von Fairness als Prinzip zu Fairness als Beweis

Für HR-Verantwortliche, Talent-Teams und Plattformanbieter verändert die unabhängig geprüfte KI die Grundlage von Vertrauen.

Fairness wird sichtbar statt vermutet. Entscheidungen werden überprüfbar und verteidigungsfähig. Risiken sinken, die Compliance-Bereitschaft steigt – ebenso wie das Vertrauen der Kandidaten.

Vor allem aber werden mehr Bewerbende gesehen und auf Basis vollständiger Informationen bewertet, statt aufgrund unvollständiger Daten vorzeitig ausgeschlossen zu werden.

Recruiting-KI mit belegbarer Fairness und unabhängiger Prüfung

Die Zukunft von Hiring-Technologie wird nicht allein durch Automatisierung bestimmt, sondern durch nachweisbares Vertrauen.

Systeme müssen nicht nur effizient und erklärbar sein – sie müssen kontinuierlich überwacht, unabhängig validiert und belegbar fair sein.

Screening in ist keine bloße Design-Philosophie. Es ist ein messbarer Schritt hin zu mehr Transparenz, Verantwortung und belastbaren Entscheidungen im Recruiting.

Sehen Sie sich hier die unabhängigen Audit-Ergebnisse und das laufende Monitoring für EQO an.